LLM 具备强大的分析能力、推理能力、生成能力,但它仍然无法记得上个月的今天发生了什么,哪怕你曾经在上个月告诉过它。

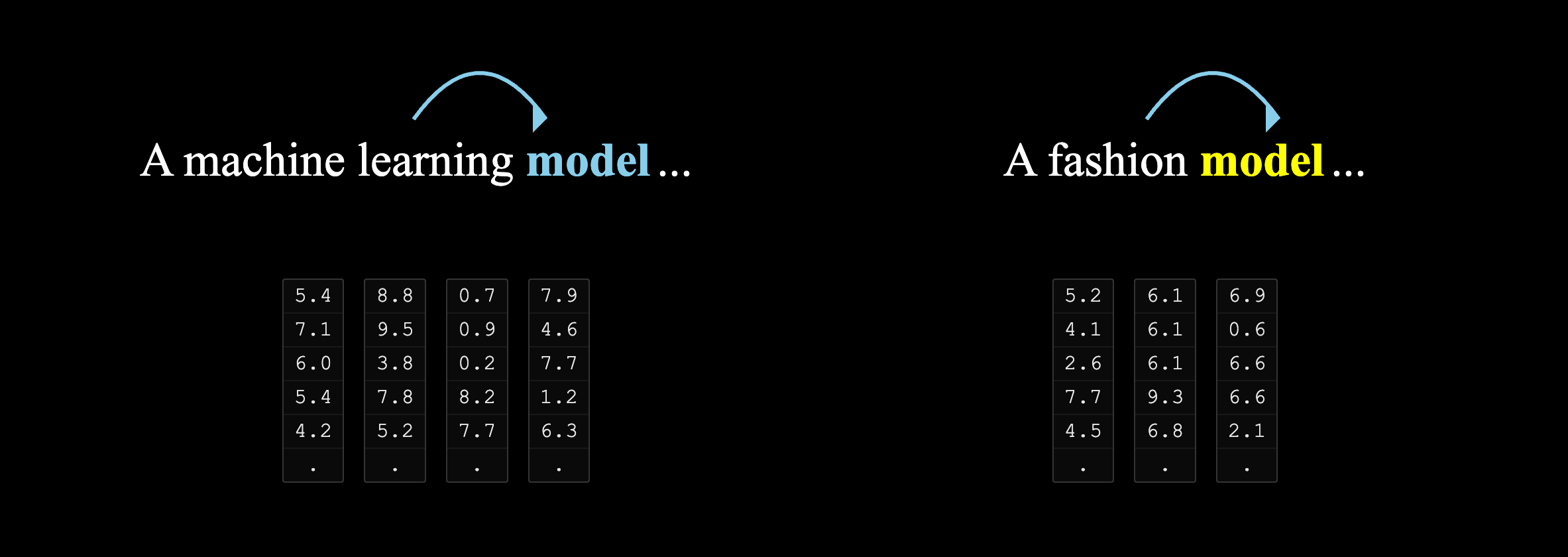

究其原因,是因为 LLM 基于静态语料库训练,你的个人经历并不在其中。它只具备短期记忆,这种记忆依靠一次对话的上下文维持(历史信息会被携带到下一次对话),当你换个对话窗口,它就忘记了。

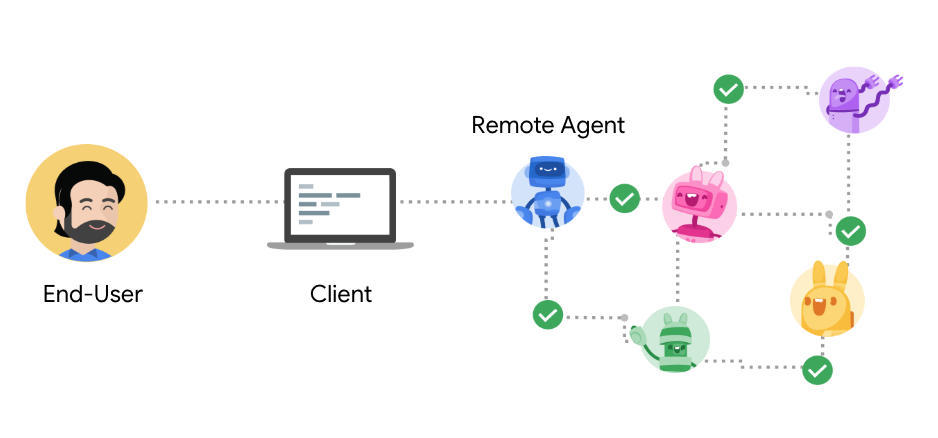

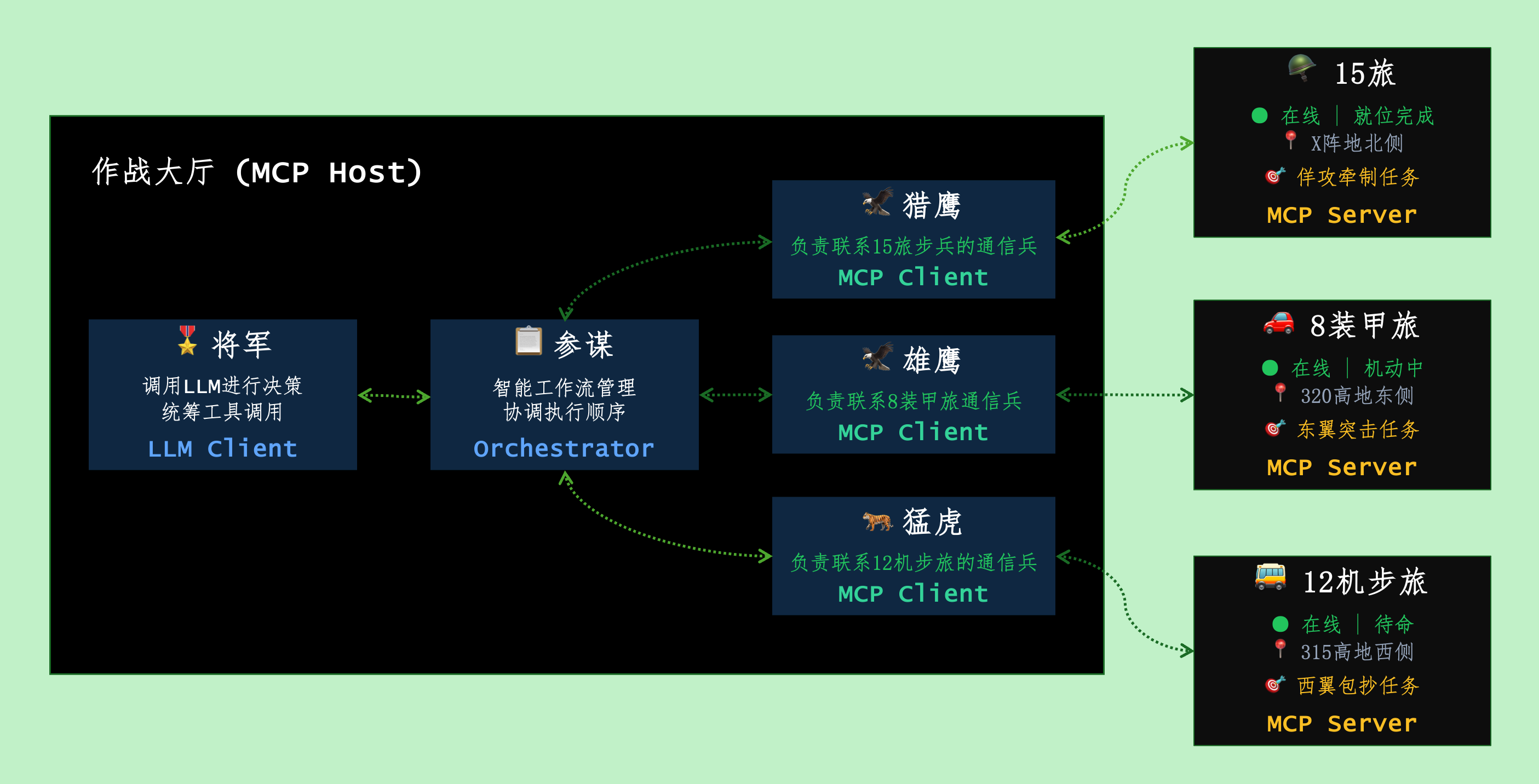

当然,现在的诸多协议已经能够为 LLM 提供很多”外挂”,比如 MCP 协议、A2A 协议,它们在不断扩展 LLM 的认知边界,让 LLM 能够跳出其固有的知识范围。但是,RAG 仍然是一个重要方向,为 LLM 提供长期记忆、让它能够将神经元触达到你的个人数据。